Reinforcement Learning: Membangun Agen Cerdas Melalui Pengalaman

Dalam lanskap kecerdasan buatan (AI) yang terus berkembang, Reinforcement Learning (RL) muncul sebagai paradigma yang kuat untuk melatih agen cerdas yang dapat membuat keputusan optimal dalam lingkungan yang dinamis dan tidak pasti. Tidak seperti supervised learning yang mengandalkan data berlabel, RL memberdayakan agen untuk belajar melalui pengalaman, berinteraksi dengan lingkungan, dan menerima umpan balik dalam bentuk reward atau penalty. Proses pembelajaran iteratif ini memungkinkan agen untuk secara bertahap menyempurnakan kebijakannya dan mencapai tujuan tertentu.

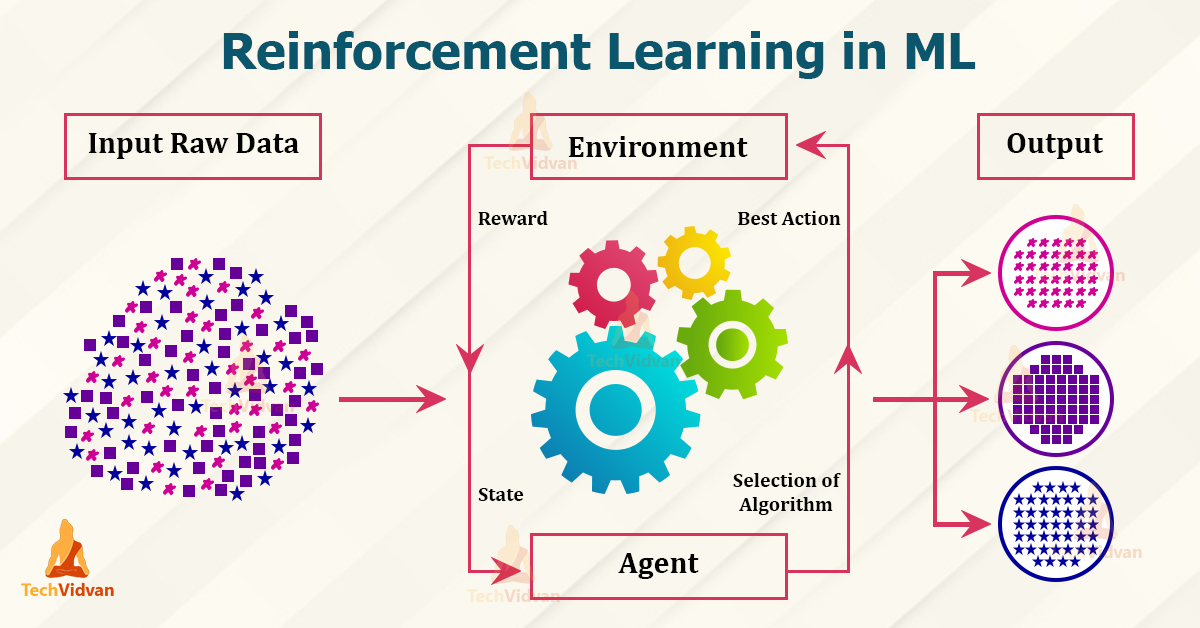

Dasar-Dasar Reinforcement Learning

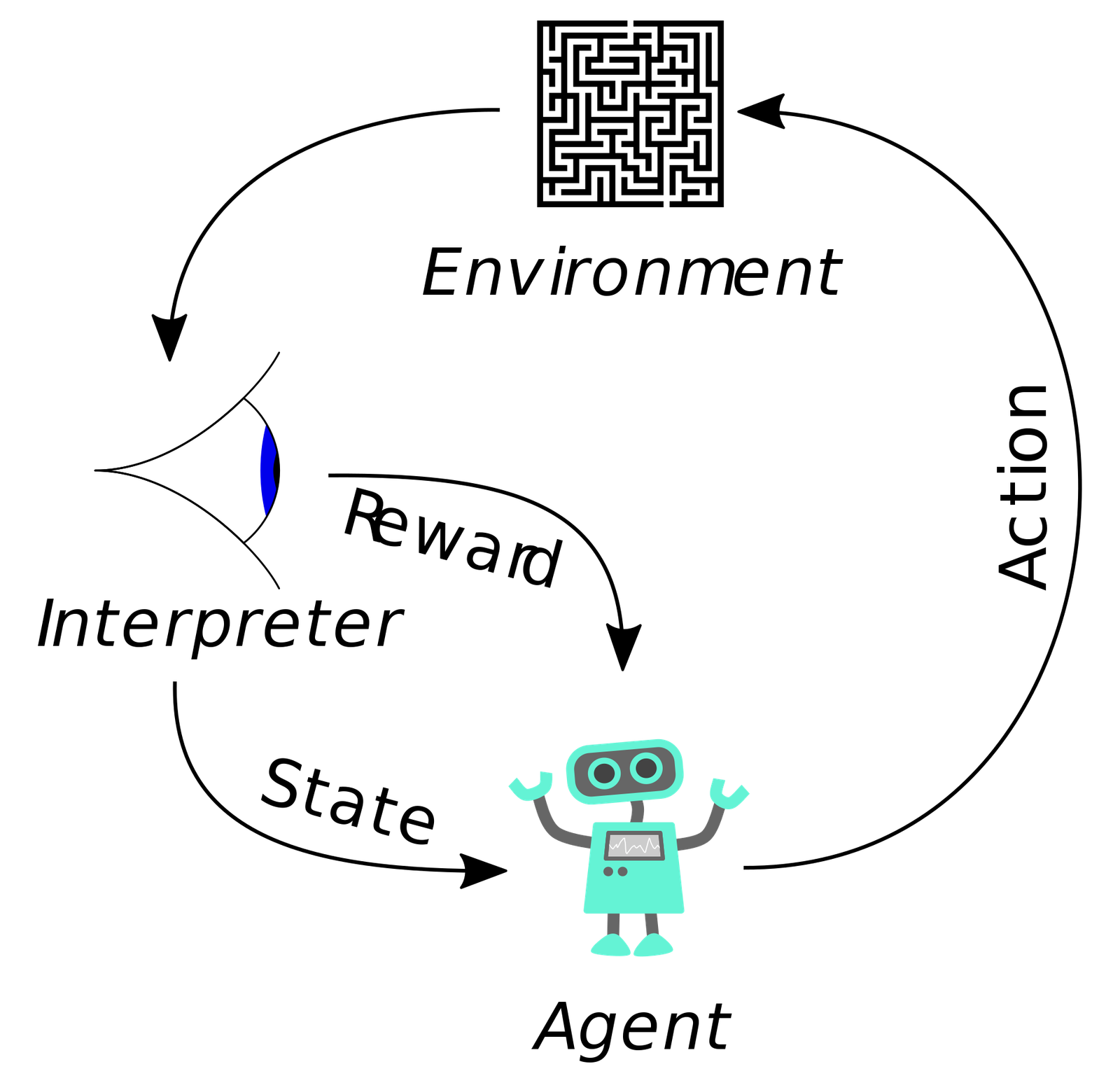

Pada intinya, RL melibatkan agen, lingkungan, state, aksi, dan reward. Agen adalah entitas yang belajar dan membuat keputusan. Lingkungan adalah dunia tempat agen beroperasi. State mewakili situasi saat ini yang dihadapi agen. Aksi adalah pilihan yang dapat diambil agen. Reward adalah sinyal umpan balik yang diterima agen setelah melakukan tindakan, menunjukkan konsekuensi dari tindakan tersebut.

Tujuan dari agen RL adalah untuk mempelajari policy optimal, yang memetakan state ke tindakan dengan cara yang memaksimalkan cumulative reward dari waktu ke waktu. Ini melibatkan penyeimbangan antara exploration (mencoba tindakan baru untuk menemukan reward potensial) dan exploitation (memilih tindakan yang diketahui menghasilkan reward tinggi).

Algoritma Reinforcement Learning Utama

Beberapa algoritma RL telah dikembangkan untuk mengatasi berbagai jenis masalah dan lingkungan. Beberapa algoritma yang paling terkenal meliputi:

Q-Learning: Algoritma off-policy yang mempelajari fungsi Q, yang memperkirakan expected reward maksimum untuk mengambil tindakan tertentu dalam state tertentu. Algoritma ini secara iteratif memperbarui perkiraan Q berdasarkan reward yang diterima dan perkiraan Q dari state berikutnya.

SARSA (State-Action-Reward-State-Action): Algoritma on-policy yang mempelajari fungsi Q dengan cara yang mirip dengan Q-learning. Namun, SARSA memperbarui perkiraan Q berdasarkan tindakan yang sebenarnya diambil oleh agen, bukan tindakan optimal.

Deep Q-Network (DQN): Perluasan dari Q-learning yang menggunakan jaringan saraf dalam untuk memperkirakan fungsi Q. Ini memungkinkan DQN untuk menangani ruang state dan aksi yang besar, membuatnya cocok untuk masalah yang kompleks.

Policy Gradient Methods: Algoritma yang secara langsung mengoptimalkan policy agen tanpa mempelajari fungsi Q. Mereka menggunakan gradien dari expected reward untuk memperbarui policy, secara bertahap meningkatkan kinerja agen. Contohnya termasuk REINFORCE dan Actor-Critic methods.

Trust Region Policy Optimization (TRPO) dan Proximal Policy Optimization (PPO): Algoritma policy gradient canggih yang bertujuan untuk meningkatkan stabilitas dan kinerja pembelajaran. Mereka menggunakan batasan atau penalty untuk mencegah policy berubah terlalu drastis selama setiap pembaruan, memastikan pembelajaran yang lebih stabil.

Aplikasi Reinforcement Learning

RL telah menunjukkan keberhasilan yang luar biasa di berbagai bidang, termasuk:

Game: RL telah digunakan untuk melatih agen untuk bermain game seperti Go, catur, dan video game Atari pada tingkat manusia super. AlphaGo, misalnya, adalah program RL yang mengalahkan juara dunia dalam Go.

Robotika: RL dapat memberdayakan robot untuk belajar tugas-tugas yang kompleks seperti navigasi, manipulasi, dan perakitan. Robot dapat belajar beradaptasi dengan lingkungan yang berubah dan mengatasi tantangan yang tidak terduga.

Keuangan: RL dapat digunakan untuk mengoptimalkan strategi perdagangan, mengelola portofolio, dan mendeteksi penipuan. Agen RL dapat belajar membuat keputusan yang menguntungkan berdasarkan data pasar dan tren.

Kesehatan: RL dapat membantu dalam merancang rencana perawatan yang dipersonalisasi, mengoptimalkan dosis obat, dan mengelola sumber daya di rumah sakit. Agen RL dapat belajar memprediksi hasil pasien dan membuat rekomendasi yang sesuai.

Optimasi Sumber Daya: RL dapat diterapkan untuk meningkatkan efisiensi energi, mengelola lalu lintas, dan mengoptimalkan rantai pasokan. Dengan mempelajari pola dan membuat keputusan yang cerdas, agen RL dapat membantu menghemat sumber daya dan mengurangi biaya.

Tantangan dan Arah Masa Depan

Meskipun RL menjanjikan, ada beberapa tantangan yang perlu diatasi:

Sample Efficiency: Algoritma RL seringkali membutuhkan sejumlah besar data untuk belajar, yang dapat mahal atau tidak praktis dalam beberapa aplikasi. Meningkatkan efisiensi sampel adalah area penelitian yang aktif.

Exploration-Exploitation Dilemma: Menyeimbangkan exploration dan exploitation bisa jadi sulit. Terlalu banyak exploration dapat menyebabkan pembelajaran yang lambat, sementara terlalu banyak exploitation dapat menyebabkan solusi suboptimal.

Reward Shaping: Merancang fungsi reward yang sesuai bisa jadi sulit. Fungsi reward yang dirancang dengan buruk dapat menyebabkan perilaku yang tidak diinginkan atau pembelajaran yang lambat.

Generalisasi: Agen RL seringkali kesulitan untuk melakukan generalisasi ke lingkungan baru atau tugas yang tidak terlihat. Meningkatkan generalisasi adalah area penelitian yang penting.

Keamanan dan Etika: Ketika RL digunakan dalam sistem dunia nyata, penting untuk memastikan bahwa agen tersebut aman, andal, dan etis. Ini membutuhkan pertimbangan yang cermat tentang nilai-nilai dan konsekuensi yang tidak diinginkan.

Arah penelitian masa depan dalam RL meliputi:

Meta-Learning: Belajar untuk belajar, memungkinkan agen untuk beradaptasi dengan cepat ke tugas dan lingkungan baru.

Hierarchical Reinforcement Learning: Memecah masalah kompleks menjadi sub-masalah yang lebih kecil dan dapat dikelola, memungkinkan agen untuk belajar secara hierarkis.

Imitation Learning: Belajar dari demonstrasi ahli, memungkinkan agen untuk menginisialisasi policy mereka dan mempercepat pembelajaran.

Inverse Reinforcement Learning: Inferensi fungsi reward dari perilaku ahli, memungkinkan agen untuk belajar tujuan dari orang lain.

Reinforcement Learning dengan Memori: Menggabungkan memori ke dalam agen RL, memungkinkan mereka untuk mengingat pengalaman masa lalu dan membuat keputusan yang lebih tepat.

Kesimpulan

Reinforcement Learning adalah bidang yang dinamis dan berkembang pesat dengan potensi untuk merevolusi cara kita membangun sistem cerdas. Dengan memungkinkan agen untuk belajar melalui pengalaman dan beradaptasi dengan lingkungan yang berubah, RL membuka kemungkinan baru untuk otomatisasi, optimasi, dan pengambilan keputusan. Saat penelitian terus berlanjut dan tantangan diatasi, RL siap memainkan peran yang semakin penting dalam membentuk masa depan AI.